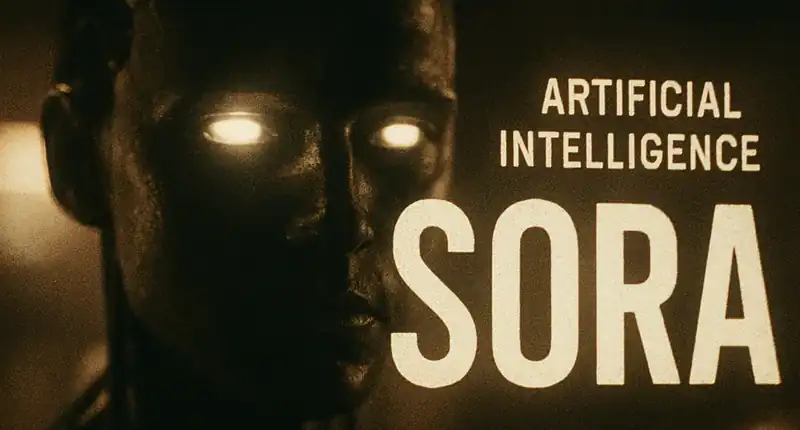

Sora, il rivoluzionario modello di intelligenza artificiale sviluppato da OpenAI, sta ridefinendo i confini della creazione di contenuti visivi. Capace di generare video realistici e fantasiosi a partire da semplici descrizioni testuali, Sora rappresenta un balzo significativo nel campo della generazione video AI. Ma come funziona esattamente questa tecnologia innovativa? Cerchiamo di spiegarlo in termini semplici.

Cos’è Sora e perché è così innovativo?

Sora è un modello di intelligenza artificiale generativa che prende un “prompt” (una descrizione testuale, come “un astronauta che cavalca un cavallo sulla luna”) e lo trasforma in un video dinamico e coerente. La sua innovazione principale risiede nella capacità di comprendere non solo le parole, ma anche il modo in cui gli oggetti interagiscono nel mondo fisico, mantenendo la coerenza visiva e temporale anche su lunghe sequenze.

A differenza di precedenti tentativi di generazione video AI, che spesso producevano clip brevi, statiche o con artefatti visivi, Sora è in grado di:

- IA superintelligente: il rischio esistenziale è reale

- Emoji Criminali: L’AI Decifra il Codice Segreto

- AI: Finta Star di ‘Squid Game’ Inganna Fan per $350.000

- Generare scene complesse: con personaggi multipli, movimenti specifici e dettagli dello sfondo accurati.

- Comprendere la “fisica” del mondo: simulando come gli oggetti si muovono e si deformano in situazioni reali.

- Mantenere la coerenza temporale: gli oggetti e i personaggi rimangono gli stessi e si comportano in modo logico per tutta la durata del video.

- Creare video di durata significativa: ben oltre i pochi secondi tipici di altri modelli.

Il cuore della tecnologia: Trasformatori e Patch

Al centro del funzionamento di Sora c’è un’architettura ispirata ai Trasformatori (Transformers), gli stessi modelli che hanno rivoluzionato il campo del linguaggio (come in GPT). Tuttavia, mentre i Trasformatori tradizionali operano su sequenze di parole, Sora applica lo stesso principio a sequenze di “patch” di dati visivi.

Immagina un video come una serie di mattoncini Lego (le patch). Ogni patch è una piccola sezione di spazio-tempo nel video. Sora viene addestrato su una vasta quantità di video reali, imparando a prevedere come queste patch si susseguono e si relazionano tra loro sia nello spazio (pixel adiacenti) che nel tempo (fotogrammi successivi).

In pratica, il processo si può semplificare così:

- Tokenizzazione del Video: Sora prende un video e lo scompone in piccole unità discrete, chiamate “patch”. Queste patch sono l’equivalente visivo dei “token” di testo usati nei modelli linguistici. Ogni patch racchiude informazioni spaziali e temporali.

- Modello di Diffusione: Sora utilizza un modello di diffusione, un tipo di modello generativo che parte da un “rumore” casuale (come una TV non sintonizzata) e lo trasforma gradualmente in un’immagine o un video coerente, guidato dal prompt testuale. È come scolpire una statua partendo da un blocco di marmo grezzo, rimuovendo il materiale in eccesso fino a rivelare la forma desiderata.

- Comprensione del Prompt: Il prompt testuale viene elaborato da un’altra parte del modello AI, che ne estrae il significato e le intenzioni. Questa comprensione profonda è fondamentale per guidare il processo di generazione del video.

- Generazione basata su “Noise”: Il modello inizia con un video di “rumore” completamente casuale (come uno schermo pieno di pixel senza senso) e, passo dopo passo, lo “denoizza” progressivamente, aggiungendo dettagli e struttura. Ad ogni passaggio, il modello utilizza la sua conoscenza delle relazioni tra le patch e le istruzioni del prompt per trasformare il rumore in un’immagine sempre più chiara e coerente, fino a generare il video finale.

Il ruolo dei “Dall-E 3 prompts”

OpenAI ha notato che i prompt dettagliati e descrittivi, simili a quelli usati per generare immagini con DALL-E 3, funzionano eccezionalmente bene anche con Sora. Questo suggerisce una sinergia tra i modelli generativi di immagine e video, dove la capacità di comprendere e interpretare un linguaggio complesso è fondamentale per entrambi.

Applicazioni e Implicazioni Future

Le potenziali applicazioni di Sora sono vastissime e toccano diversi settori:

- Intrattenimento: Creazione rapida di storyboard, prototipi di film, animazioni e effetti speciali.

- Marketing e Pubblicità: Generazione di spot pubblicitari personalizzati o contenuti promozionali.

- Educazione: Creazione di materiali didattici interattivi e simulazioni.

- Design: Visualizzazione di prodotti e ambienti in modo dinamico.

Tuttavia, come ogni tecnologia potente, Sora solleva anche importanti questioni etiche e sociali, come il potenziale per la disinformazione (deepfake) e l’impatto sul mercato del lavoro creativo. OpenAI ha dichiarato di essere impegnata nello sviluppo responsabile di queste tecnologie, includendo misure di sicurezza e la ricerca sulle filigrane per identificare i contenuti generati dall’AI.

Sora non è solo uno strumento per creare video; è un passo avanti nella capacità delle macchine di comprendere e simulare il nostro mondo, aprendo nuove frontiere per la creatività e l’innovazione.

Fonti Attendibili e Autorevoli:

- OpenAI Blog Post su Sora: https://openai.com/sora (Fonte primaria e ufficiale)

Mi occupo di fornire agli utenti delle news sempre aggiornate, dal gossip al mondo tech, passando per la cronaca e le notizie di salute. I contenuti sono, in alcuni casi, scritti da più autori contemporaneamente vengono pubblicati su Veb.it a firma della redazione.