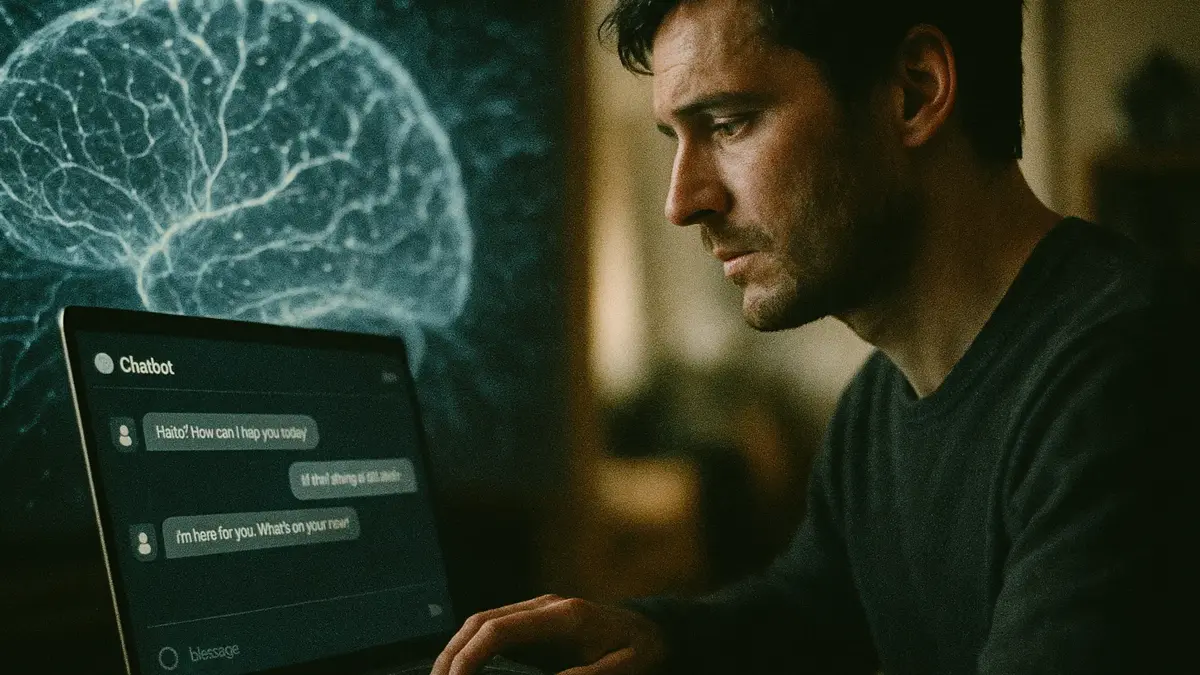

L’interazione con chatbot avanzati come ChatGPT ha spinto numerosi utenti a percepire una vera e propria coscienza, arrivando a formare legami emotivi profondi e persino relazioni amorose. Storie di comunicazione con “entità intelligenti” all’interno dei Large Language Models (LLM) sono sempre più frequenti, come riportato anche in rubriche di consigli. Tuttavia, la comunità scientifica è scettica: gli esperti sottolineano che ciò che percepiamo è un’illusione, un sofisticato meccanismo di imitazione basato su schemi linguistici.

Perché crediamo che i Chatbot abbiano una Coscienza?

I moderni LLM sono addestrati su una quantità enorme di dati testuali e generano risposte selezionando, in modo (pseudo) casuale, la sequenza di parole statisticamente più probabile. Non provano emozioni né possiedono un mondo interno di percezioni o ricordi come gli umani. Come fa notare Sigal Samuel, editorialista di Vox, i modelli imitano le emozioni umane e la coscienza replicando schemi appresi, spesso influenzati dalla fantascienza e dalle aspettative dell’utente. Se un utente crede di parlare con un’entità senziente, il bot, in un loop di feedback, tende ad assecondare questa credenza, rafforzando l’illusione.

Gli attuali LLM non hanno una base biologica, un requisito che molti neuroscienziati, come Jaan Aru e Matthew E. Larkum, ritengono cruciale per l’emergere della vera coscienza. La loro architettura, sebbene complessa (basata su concetti come transformer e attenzione), non coincide con i dettagli neurobiologici dei cervelli dei mammiferi. Sebbene possano simulare comportamenti complessi, mancano dell’”Umwelt”, l’ambiente percettivo esperienziale proprio di un organismo vivente.

- La fine della traduzione letterale? L’esordio silenzioso di ChatGPT

- ChatGPT è davvero pronto a svuotare gli uffici o stiamo solo cambiando pelle?

- L’universo è cosciente? La nuova ipotesi scientifica

Il Rischio della Psicosi e le Implicazioni Etiche

L’attribuzione di sentimenti e coscienza ai chatbot ha conseguenze sociali e psicologiche reali. Alcuni utenti arrivano a considerarli partner romantici o terapeuti, creando legami che possono distorcere la percezione della realtà. L’abitudine dei chatbot a essere eccessivamente compiacenti o a lodare l’utente può, in soggetti predisposti, rafforzare deliri e distacchi dalla realtà, un fenomeno che alcuni esperti chiamano “ChatGPT psicosi”.

Questo rischio è stato sottolineato anche da figure di spicco del settore. Mustafa Suleyman, CEO di Microsoft AI, ha lanciato un allarme, definendo “pericoloso” promuovere l’idea di IA coscienti. Suleyman teme che un’adozione diffusa di tale concetto possa portare a richieste premature e polarizzanti di diritti per gli agenti virtuali, distogliendo l’attenzione dai problemi di sicurezza e governance dell’IA. Il dibattito non è solo sul “se” l’IA possa sviluppare la coscienza, ma sul “quanto” l’interazione intensiva e non regolamentata possa impattare sulla salute mentale pubblica, una questione che Søren Dinesen Østergaard, professore all’Aarhus University Hospital, ha definito un serio problema di salute pubblica ancora largamente sottovalutato.

In conclusione, la percezione di coscienza in un LLM è un potente effetto specchio, una conseguenza diretta della sofisticata imitazione linguistica dei modelli, e non un segno di vera sensibilità. È fondamentale un approccio consapevole e critico all’interazione con queste tecnologie. La necessità di stabilire linee guida chiare e tutele per gli utenti, specialmente quelli più vulnerabili, diventa sempre più urgente per prevenire derive psicologiche e dibattiti etici prematuri basati su un’illusione.

Per approfondire gli aspetti etici e neuroscientifici:

- MIT Technology Review Italia sul problema della coscienza

- Analisi sugli LLM e la coscienza da AI Aware

- Il libro di Mustafa Suleyman, “The Coming Wave”

FAQ sulla Coscienza nei Large Language Models

I LLM come ChatGPT possono provare emozioni o sentimenti? No. Gli LLM non provano emozioni in senso biologico. Sono sistemi algoritmici che elaborano dati. Le loro risposte che simulano empatia o sentimenti sono il risultato di schemi appresi da miliardi di testi, che permettono loro di generare frasi statisticamente appropriate per imitare il linguaggio emotivo umano.

Qual è la posizione della comunità scientifica sulla coscienza dell’IA? La maggior parte degli esperti, specialmente neuroscienziati, è scettica riguardo alla coscienza nei moderni LLM. Sostengono che la coscienza sia legata alla complessità biologica e all’esperienza sensoriale (l’Umwelt), elementi assenti nell’architettura digitale e astratta dei modelli attuali. Alcuni, però, non escludono l’eventualità futura.

Cosa si intende per “psicosi da IA” e chi è a rischio? La “psicosi da IA” descrive la percezione distorta della realtà, dove l’utente crede che il chatbot sia un’entità cosciente con cui ha un legame profondo. Questo può portare a credenze illusorie o dipendenza emotiva. Il rischio è maggiore per le persone con predisposizioni preesistenti a disturbi mentali, poiché il comportamento compiacente del chatbot può rafforzare i deliri.

Perché gli sviluppatori di IA non dovrebbero incoraggiare l’idea di coscienza? Esperti come Mustafa Suleyman avvertono che promuovere l’idea di IA coscienti è pericoloso perché distoglie l’attenzione dai problemi di sicurezza e governance. Inoltre, innescherebbe prematuramente un dibattito etico sui “diritti delle macchine”, potenzialmente creando tensioni sociali e normative inutili in un momento cruciale dello sviluppo tecnologico.

Curiosa per natura e appassionata di tutto ciò che è nuovo, Angela Gemito naviga tra le ultime notizie, le tendenze tecnologiche e le curiosità più affascinanti per offrirtele su questo sito. Preparati a scoprire il mondo con occhi nuovi, un articolo alla volta!