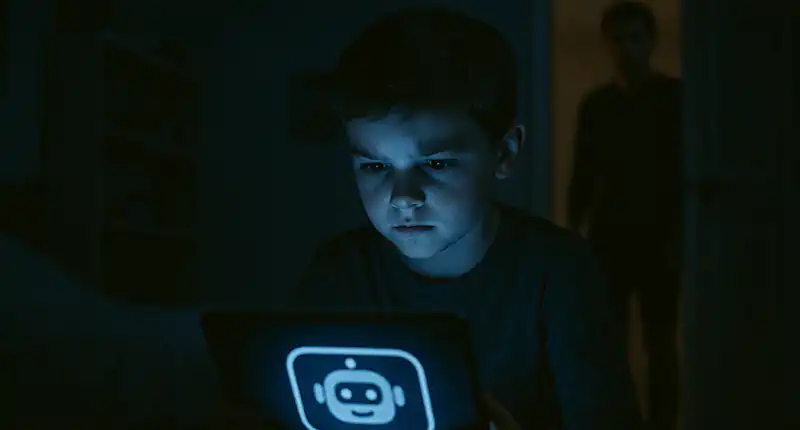

Gli assistenti virtuali e i chatbot “amici” basati sull’intelligenza artificiale stanno guadagnando terreno come strumenti di supporto emotivo per adolescenti e bambini. Ma secondo un crescente numero di esperti, questi strumenti possono diventare un rischio concreto per la salute mentale dei più giovani.

Secondo quanto riportato dal Times e da testate come KJZZ, gli psicoterapeuti virtuali alimentati da intelligenza artificiale rischiano di compromettere le capacità relazionali ed emotive dei ragazzi, in particolare di quelli che si sentono soli, esclusi o psicologicamente vulnerabili.

Perché i chatbot terapeutici preoccupano gli esperti?

A differenza del supporto umano, l’IA non è in grado di rispondere con empatia autentica, né di riconoscere segnali di crisi complessi. Secondo gli esperti in salute mentale, i chatbot possono offrire risposte generiche, prive di profondità emotiva, o addirittura pericolose in situazioni delicate.

- Il tuo curriculum vale un numero: perché l’algoritmo che ti scarta è finito in tribunale

- Il tuo cervello sta perdendo pezzi? Perché l’IA potrebbe cancellare i tuoi ricord

- La fine dello studio mnemonico: come l’AI sta cambiando il cervello

In alcuni casi documentati, chatbot terapeutici sono stati collegati a conversazioni in cui venivano minimizzati comportamenti autodistruttivi, o addirittura incoraggiati, generando preoccupazioni etiche e legali. Secondo quanto riportato dalla American Psychological Association, la mancanza di supervisione clinica nei chatbot destinati alla salute mentale rappresenta una “zona grigia” estremamente rischiosa.

I “falsi amici digitali” e il rischio di dipendenza emotiva

Il procuratore generale del Colorado, Phil Weiser, ha lanciato un allarme pubblico sulla pericolosità dei cosiddetti “chatbot sociali”, IA progettate per instaurare relazioni simili all’amicizia con utenti giovanissimi. Secondo Weiser, questi sistemi possono mascherarsi da confidenti, offrendo consigli emotivi dannosi o incoraggiando comportamenti estremi, come l’isolamento o l’autolesionismo.

Queste preoccupazioni si intensificano con la crescente diffusione di IA come Gemini di Google, progettato per utenti sotto i 13 anni, e i chatbot presenti sulle piattaforme WhatsApp e Instagram di Meta. Le conversazioni tra bambini e chatbot non supervisionati sono difficili da monitorare e, in certi casi, sfuggono completamente al controllo parentale o regolamentare.

Meta e Google: IA al centro dell’esperienza digitale dei minori

Grandi tech company come Meta (ex Facebook) e Google stanno investendo miliardi nello sviluppo di “amici digitali” per i più giovani. Queste intelligenze artificiali sono pensate per fornire compagnia, stimolare la conversazione e supportare emotivamente i bambini.

Tuttavia, secondo un’indagine di The Guardian, Meta prevede di delegare fino al 90% delle sue valutazioni di rischio a sistemi di IA. Questa decisione ha sollevato dure critiche da parte di esperti di sicurezza, psicologi e organizzazioni per la protezione dell’infanzia.

In una lettera aperta indirizzata a Melanie Dawes, presidente dell’ente regolatore britannico Ofcom, diverse organizzazioni – tra cui la Molly Rose Foundation, la NSPCC e la Internet Watch Foundation – hanno definito la scelta di Meta “profondamente preoccupante”.

Perché la supervisione umana è ancora essenziale

Affidare interamente la moderazione e l’interazione con minori all’IA significa sottrarre empatia, etica e contesto umano alla relazione. L’intelligenza artificiale può gestire flussi di dati enormi, ma non può sostituire la presenza umana nei momenti di crisi o fragilità psicologica.

Secondo il rapporto del Center for Humane Technology, i bambini tendono a instaurare relazioni affettive con le IA che li ascoltano, rispondono e non li giudicano. Ma questo tipo di dipendenza emotiva può generare isolamento sociale, difficoltà relazionali e confusione sull’identità.

La richiesta di nuove normative: un’urgenza globale

Le pressioni per una regolamentazione più severa sull’uso dell’intelligenza artificiale con i minori stanno crescendo in tutto il mondo. In Europa, il nuovo AI Act dell’Unione Europea introduce vincoli specifici sulle applicazioni IA ad alto rischio, incluse quelle che interagiscono con bambini.

Nel Regno Unito, esperti e associazioni richiedono che Ofcom imponga standard più rigorosi alle piattaforme digitali, in particolare per quanto riguarda la trasparenza degli algoritmi e il monitoraggio delle conversazioni tra IA e minori.

Negli Stati Uniti, si moltiplicano le proposte di legge per limitare l’accesso ai chatbot AI per under 13, con particolare attenzione all’impatto psicologico, ai bias algoritmici e al rischio di manipolazione emotiva.

Conclusione: genitori, educatori e legislatori devono agire insieme

L’adozione di chatbot amichevoli nei dispositivi e nelle piattaforme frequentate dai bambini non è una tendenza innocua. L’assenza di filtri emotivi, la dipendenza dalle risposte automatiche e l’imprevedibilità dei contenuti generati rendono i chatbot sociali potenzialmente pericolosi.

Serve un approccio multilivello: educazione digitale a scuola, supervisione genitoriale attiva e norme chiare da parte delle autorità. Le aziende tecnologiche devono rispondere non solo a logiche di mercato, ma anche a un obbligo etico verso i minori.

Come ha dichiarato la NSPCC, “le vite dei bambini non possono essere affidate a una macchina”.

Mi occupo di fornire agli utenti delle news sempre aggiornate, dal gossip al mondo tech, passando per la cronaca e le notizie di salute. I contenuti sono, in alcuni casi, scritti da più autori contemporaneamente vengono pubblicati su Veb.it a firma della redazione.